【AI狂牛病】AIイラストで画像生成AIが学ぶデータ崩壊が起こりつつある

画像生成AIモデルは、膨大なサンプルから学習し、新たな画像を生み出します。

その結果、今やネット上にはAI画像があふれています。

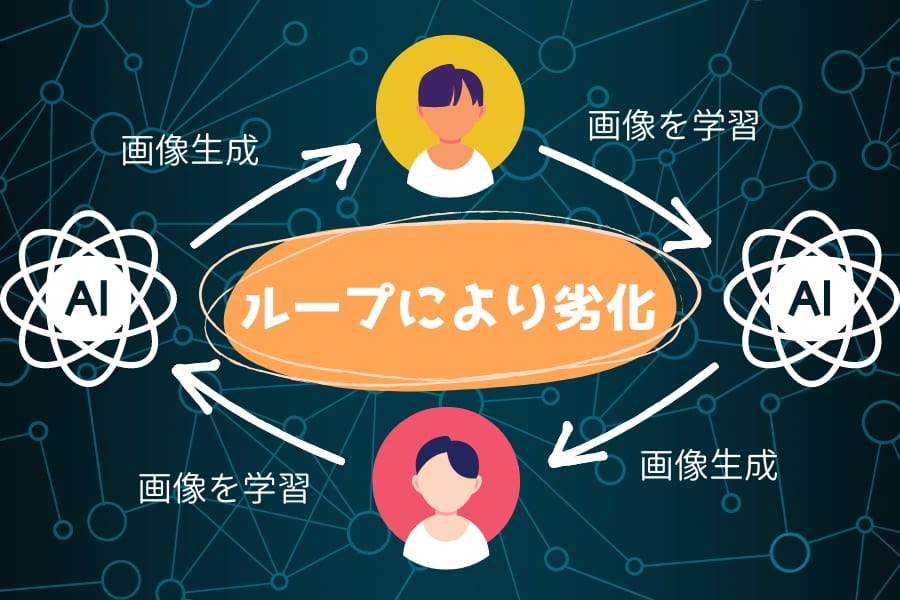

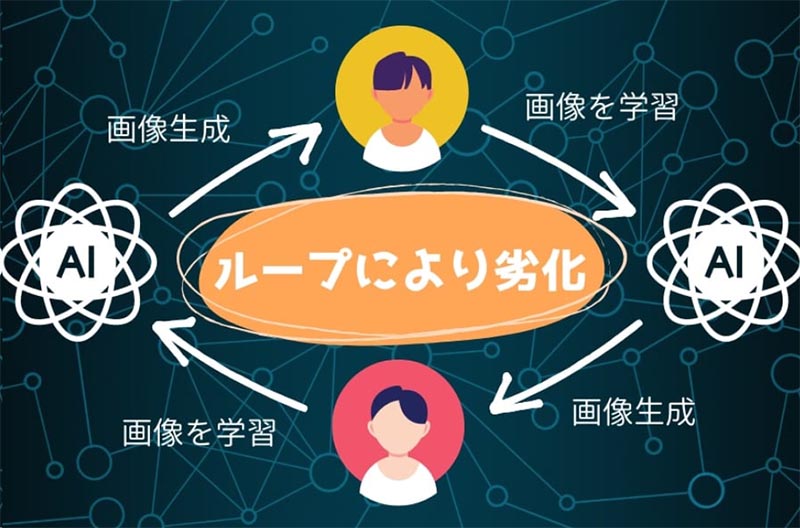

では、AIモデルが、知らず知らずのうちにAI画像を取り入れて学習するようになると、どうなるのでしょうか。

アメリカのライス大学(Rice University)に所属するリチャード・G・バラニューク氏ら研究チームは、生成AIモデルが合成データを学習して新たな合成データを生成するループが生じると、生成される合成データの品質はどんどん劣化していくと報告しました。

研究チームは、こうした状況を狂牛病(ウシにウシの肉骨粉をエサとして与える行為で蔓延した疾患)になぞらえています。

そして現在、静かに「AI狂牛病」が広がっているかもしれません。

この研究は2024年5月オーストリア・ウィーンで開催された深層学習分野の国際会議「ICLR 2024」で発表されていて、論文はプレプリントサーバーarXivに公開されています。

目次

ウシがウシを食べて広がる「狂牛病」

一時期、狂牛病(正式名称は「牛海綿状脳症」)が大きな話題を呼びました。

これは1986年、イギリスで最初に報告されたウシの病気であり、狂牛病にかかったウシは、脳の中に空洞ができてスポンジ状になります。

潜伏期間は数カ月から数年であり、発症後は、異常行動・運動失調(群れから離れたりけいれんを起こしたりする)などの神経症状を示し、2週間~半年で死に至ります。

この狂牛病が蔓延した原因は、簡単に言うと、「ウシがウシを食べること」でした。

そもそも狂牛病は、健康なウシも持っている「プリオン」というタンパク質が異常化したものによって生じたと考えられています。

そして狂牛病のウシを原料とした肉骨粉を、他のウシにエサとして与えたことで多くのウシが狂牛病に感染しました。

世界ではこれまでに19万頭あまり(うちイギリスで約18万5000頭)の狂牛病のウシが見つかっています。

そして現在、全く分野の異なるAIの世界で、狂牛病に似た恐ろしい現象が生じ始めています。

次世代AIモデルの開発における課題

生成AIモデルは、既存のサンプルから学習して、新たな合成データを生み出すことができます。

例えば、様々な人間の顔写真でトレーニングした生成AIモデルは、実在しない人間の顔の画像を新たに作成することができます。

最近ではAIの性能が高まっているため、AI画像と本物の写真を見分けることは容易ではありません。

また、ネット上には様々なAI画像があふれるようになりました。

しかしライス大学の研究によると、この状況は次世代のAIモデルを開発する際、大きな問題を引き起こす恐れがあります。

新しいAIモデルを開発し、トレーニングするためには膨大な量のオリジナルデータが必要であるため、開発者たちはその供給に難儀することになります。

そのため、次世代AIモデルのトレーニングでは意図的に、AI生成データが使用されたり、ネット上の情報で学習することで知らない内にAI生成データで学習してしまう可能性があるのです。

つまり、「AIにAIが生成したデータを与える」現象が生じるわけです。

AIの作った文章にしろ、AI生成画像にしろ、人間の目にもわかりやすい問題を抱えている場合がよくありますが、こうした欠陥を含んだデータで新しいAIモデルが学習してしまうと、生成されるデータ(画像、テキスト、その他のデータ含む)の品質と多様性かどんどん低下していく恐れがあります。

そこで今回の研究チームは、AIにAI生成データを与えて学習させた結果、どのような現象が生じるのか実験を行いました。

AIが生成したものをAIが取り込んで劣化していく「AI狂牛病」

生成AIモデルをトレーニングするためのデータは、インターネットから取得されることが少なくありません。

そのため現在のように合成データがネット上で急増すると、「AIモデルが過去に作られた合成データを取得 → それを元にAIモデルが合成データを生成 → 次世代AIモデルがその合成データを取得」というループが発生する可能性があります。

今回、バラニューク氏ら研究チームは、そのようなループの結果何が起きるかを、画像生成AIを用いて調査しました。

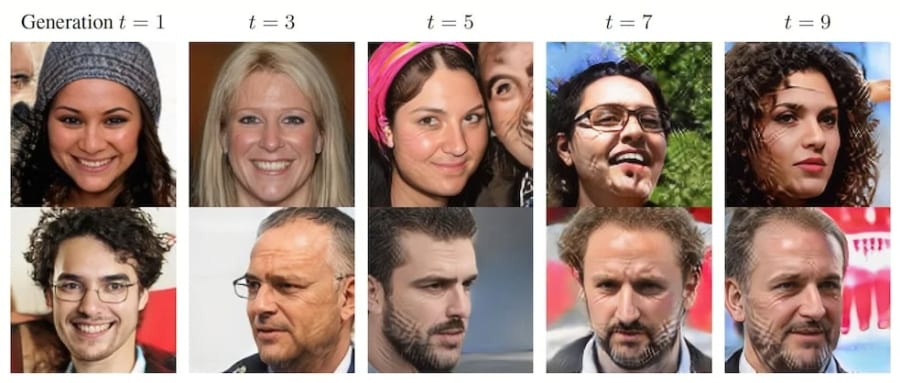

その結果、ループが繰り返されるにつれて、AIモデルが生成する画像の質が劣化していくと分かりました。

例えば、あるケースではループが繰り返されるうちに、生成された人物画像には、格子状の模様が強く現れるようになりました。

第1世代の生成画像は本物と見分けがつかないのに対し、第9世代の生成画像の方が明らかに画質が劣化してしまっています。

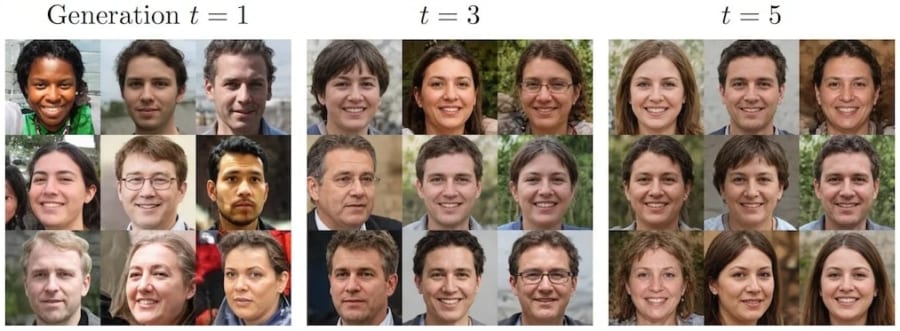

一方で、データの品質を維持しようとした場合、ループによって多様性が失われることが分かりました。

AIモデルは品質を維持するのに効果的なデータを選別するようになり、結果として生成される画像は、世代を重ねるごとにどんどん似てくるのです。

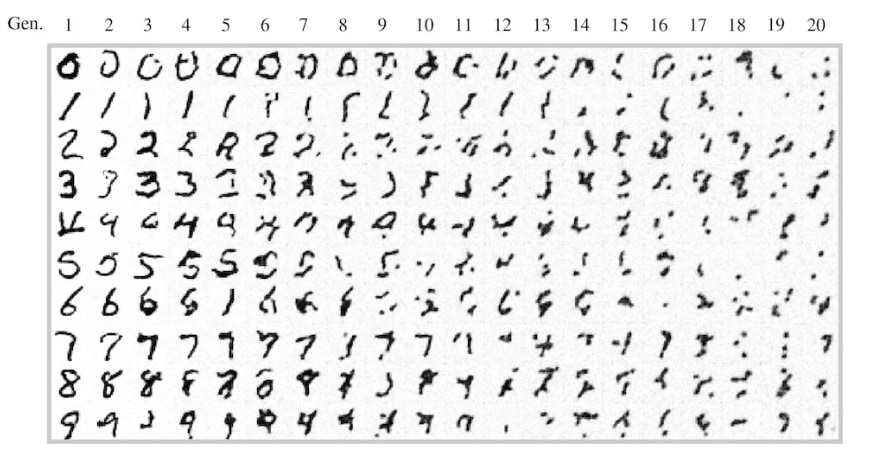

「手書きの数字」の画像を使ったテストでは、ループによって数字が徐々に判読不能になりました。

この悲惨な現象は、ウシにウシを与えることで生じた「狂牛病の蔓延」に類似していることから、研究者は「モデルオートファジー障害(Model Autophagy Disorder (MAD))」と呼んでいます。

現在、そして将来のAIの世界では、AIにAIを与えることで、まさに「AI狂牛病」とも言える現象が生じていくかもしれません。

(※「AI狂牛病」という名称は存在しません。研究者は狂牛病との類似性を指摘していますが、研究者はこの現象をMADと名付けています)

バラニューク氏も、この課題を何世代にもわたって放置すると、「インターネット全体のデータ品質と多様性が損なわれる」と指摘しています。

「生成AIモデルの開発」と「合成データの生成」が盛んに行われているまさに今、「AI狂牛病」は静かに広がっているのかもしれません。

マイコメント

この問題はAIが私たちの日常に深く浸透するに従い深刻な問題を引き起こす可能性が

あります。

それは何が正しく何が間違いであるかという基準が徐々に曖昧になって行き、AIが

これが正しいものであるというものを提供してもそれが正しいと言えなくなるからです。

先日もAIの文章の劣化問題を取り上げましたが、AIがネット上の文章を学習する

スタイルを取る限り、データを学習する際にそれがAIが作ったものであるかどうか

検証して、人が作ったものであると決定したデータを取り込まない限りもの問題は

解決しません。

AIはこれからの社会の便利な利器になると言われていたものが、今まさにこれまで

気づかなかった問題に直面していると言えます。

コメント